家里之前都是一些配置很低的电脑,全部装了centos后组成k8S集群,然后打造自己的工具生态,提升自己的工作效率和生活便利性。现在AI比较火,想着也来体验一下,结果发现家里现有的机器配置都太老了,根本没办法玩,如果买各大云服务商的GPU服务器的话,那个价格又直接把我劝退~~

最终决定买配件自己组一台!每天只需要花一点电费就可以拥有语言、图形、音频等领域的大模型工具,不香吗?

京东、淘宝、拼多多逛了个遍,最终购买的配件如下:

| 配件 | 价格 | 购买途径 |

|---|---|---|

| 主板+cpu:精粤X99M PLUS D4+2680V4 | 373.8 | 拼多多 |

| CPU散热 X79/X99专用 杂牌 | 32.46 | 淘宝 |

| ddr4:三星32g 2400(4R*4)*2 | 423.52 | 拼多多 |

| 硬盘:七彩虹m.2 1T | 338.8 | 京东 |

| 显卡:tesla p40 24G | 823 | 淘宝 |

| 显卡散热器:涡轮散热器 | 48 | 淘宝 |

| 电源:鑫谷全模组850W | 398.98 | 淘宝 |

| 机箱:开放机箱 | 48 | 拼多多 |

总共花费加起来2486.56大洋。看看京东跑大模型的机器价格,入门款都要八九千。这价格算是够便宜了。

各个配件到手后着手组装,有几个注意点:

1、tesla p40 24G没有图形显示,是专业的计算卡,安装centos的时候先插其他亮机显卡,系统安装成功后再换上tesla p40。

2、在换上tesla p40之前需要进入bios,找到above-decoding-4g选项,把他打开,不然会报错。

3、tesla p40需要250w供电,需要提供两个6Pin供电,卖家送了我一个分线器,没有的话得单独买一个。

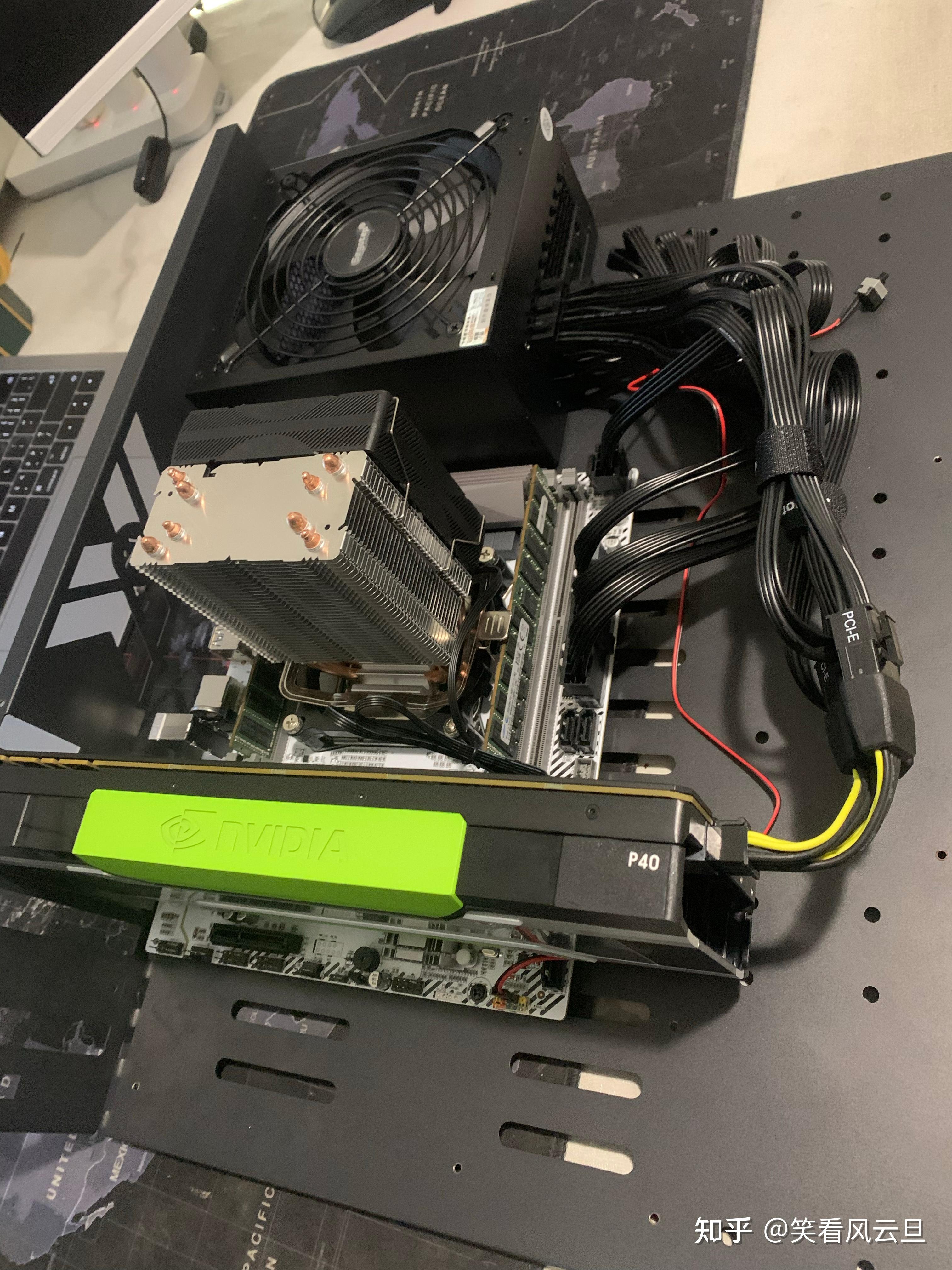

本人安装的过程还是非常顺利的,没有任何卡壳的地方,最终机器效果如下:

由于我装机的时候,显卡的涡轮风扇还没到呢,所以这里还没有安装,装上会很长,所以庆幸我买的是这种开放的板子,正常机箱应该都装不下。

涡轮风扇虽然没到,但不影响我提前体验,我把家里的电风扇搬过来对着他吹,而且最近天气变冷了,温度控制的很低,由于tesla p40 24G是被动散热,风扇是非常有必要的,没有风扇,他的温度分分钟上90,很危险!

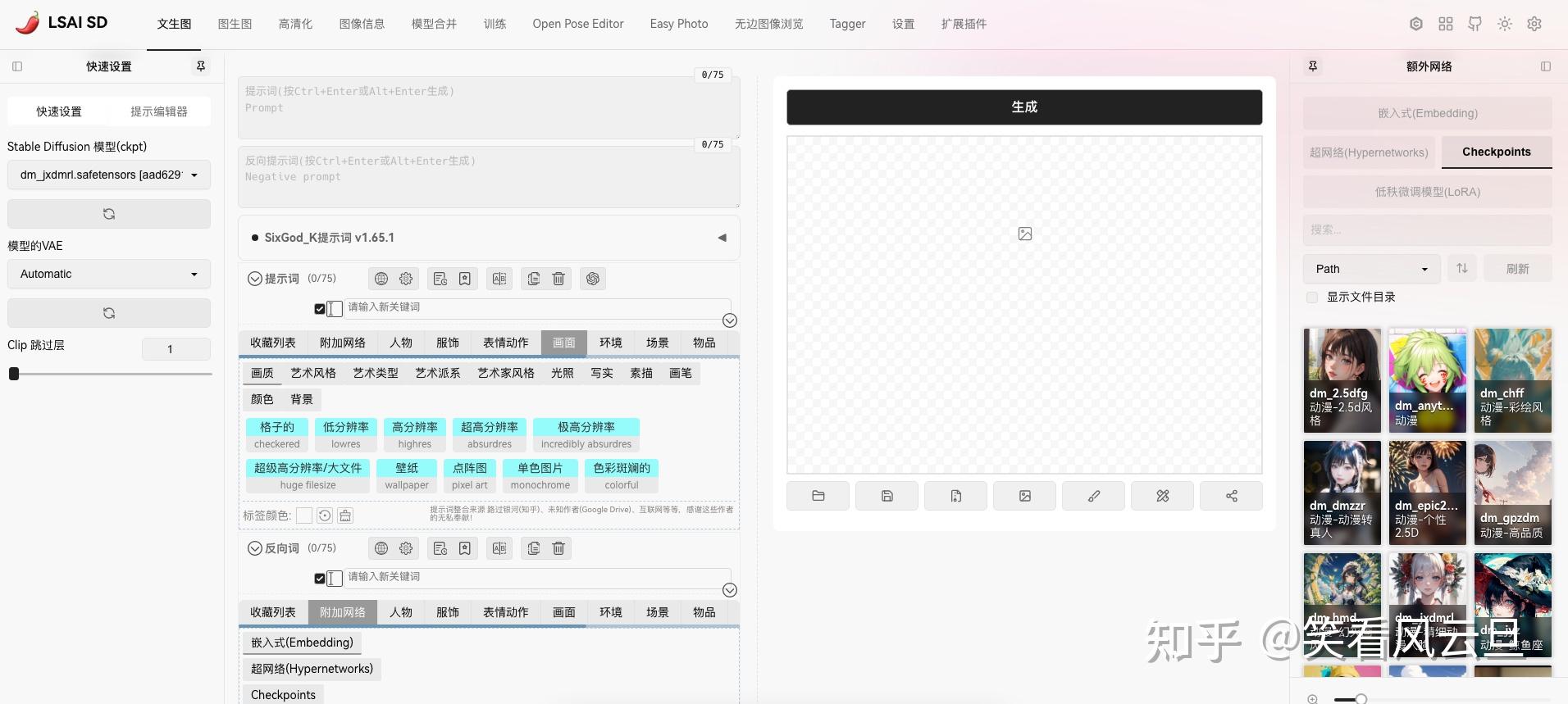

系统安装完成后,安装nvidia驱动、docker、再以docker的方式部署stable Diffusion开始体验(安装细节后面单开一篇文章分享)。下面来看看两千出头的机器,出图效果:

先秀一下改完主题和插件的stable Diffusion主界面:

先来三张真人模型,768×768

再来两张二次元模型,768×768

平均一下,一张768×768的高清图,生成大概需要15-18秒,还不错!

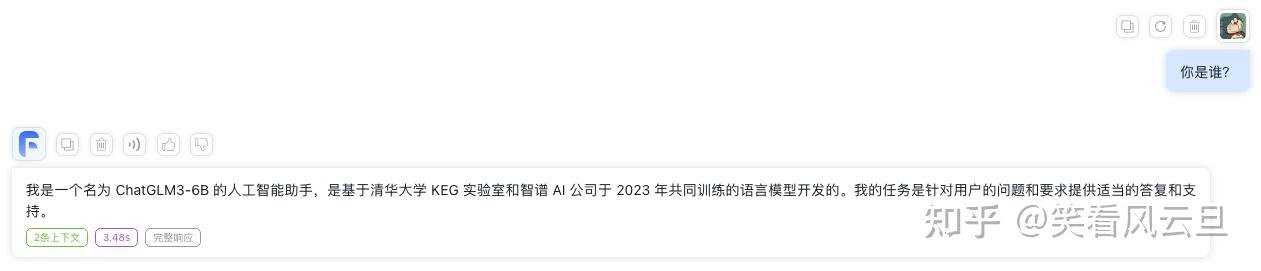

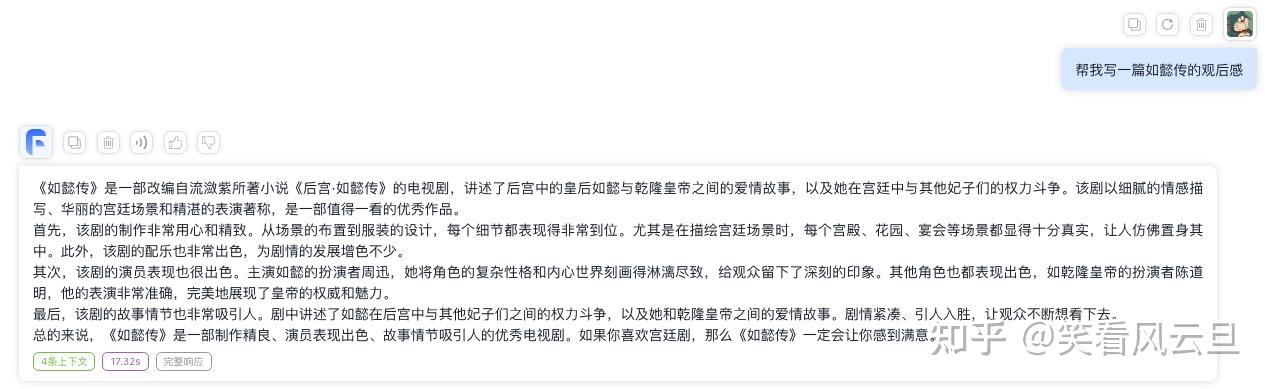

再来体验下语言模型,同样的,为了不污染宿主机,仍然使用docker的方式,部署了清华开源的chatglm3-6b语言模型。

很不错,出字速度很快,大概一秒吐20-30个,对话很流畅,我之前体验用cpu部署一些语言模型,三秒钟吐一两个字,完全不能忍。

非常流畅!想要入坑AI领域的小伙子们可以下手了!